【每周快報】1105-1111 AWS 服務更新

前言

AWS 這周推出了高達二十多項的服務更新,包含了機器學習、資料庫、容器服務…等各領域的服務。其中對於許多使用者來說最有感觸的莫過於 DynamoDB 的更新,現在它可以支援匯出 Table 資料,在使用上較以往方便許多。另外,AWS 也持續推出許服務讓使用者能以更經濟實惠的方式來操作,這周 AWS 為 S3 Intelligent-Tiering 新增了 Archive Access Tiers,有了這項新服務後,它會自動偵測有了這項新服務後,它會自動偵測物件的存取次數,並自動轉換到最合適的存取類型,替使用者節省了不少成本。

本周我們也會向各位介紹 AWS Gateway Load Balancer、Amazon Elasticsearch Service、Amazon ECS、AWS Storage Gateway…等多項服務的更新及改善。

焦點新聞

AWS Gateway Load Balancer 正式 GA

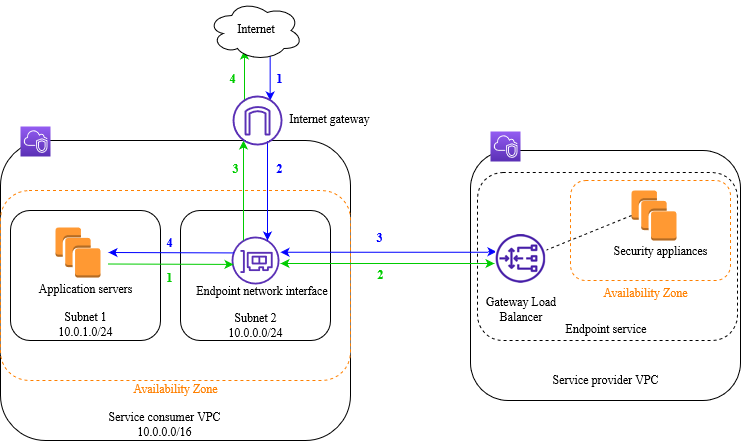

AWS 在去年新增了 VPC Ingress Routing,用來允許所有進出 IGW 或 VGW 的流量路由到特定 EC2 的 ENI 上進行流量檢查,透過此方法可以在流量進入後端應用程式前先進行檢查或阻止可疑流量進入。

但儘管啟用 EC2 非常輕鬆簡單,但是確保 HA 和擴展卻得由使用者來處理,使用者必須針對篩選流量的 EC2 進行 HA 配置,或者針對流量來設定擴展機制,更何況還有些使用者會選擇使用第三方軟體,上述所有舉動都會增加使用者的成本與麻煩。

此次更新後,AWS 全新推出了 Gateway Load Balancer(GWLB),作用於 OSI 第三層(網路層),預設會監聽所有流入 6081 port 的封包,走的是 GENEVE(Generic Network Virtualization Encapsulation)協議,因此可讓 GWLB 保留原封包內容,以確保封包經過流量檢測後仍能送至後端應用程式。

使用者可將流量先導入 GWLB 的 endpoint 中,GWLB 會將流量轉發到指定的 Target group(使用者自己用來處理流量的 EC2 或第三方 Partner VPC 中的 EC2)中。

此圖流量先由 IGW 進入,透過 GWLB endpoint 進入 Partner VPC 處理流量(防火牆)隨後在轉送回後端應用程式當中。

GWLB endpoint 的路由規則也是透過路由表來設置,並且是與 VPC endpoint 相同的技術做傳輸,所以當使用者選擇使用第三方 Partner 所提供的解決方案時,也能夠安全的將流量路由至 Partner VPC 中。

Amazon DynamoDB 支援匯出 Table 資料

Amazon DynamoDB 是一個全託管的非關連式資料庫,無伺服器的設計讓使用者無需管理基礎設施,因此擁有眾多的使用者,以往使用者若想將 Table 中的資料匯出至 S3 或下載以利後續應用時,都需要自行撰寫腳本將資料匯出,對於使用者來說是一件很麻煩的事情。

此次更新後,DynamoDB 新增以下功能:

- 下載為 CSV

- 匯出至 S3 bucket

對於在做資料分析或有資料導出需求的使用者是一大福音,而在 匯出至 S3 Bucket 的功能中並不會消耗 Capacity unit 所以使用者不需要擔心效能與成本上的疑慮。

Amazon S3 Intelligent-Tiering 新增 Archive Access Tiers

Amazon S3 Intelligent-Tiering 是 S3 所提供的其中一種儲存方案,主要目的為透過自動化的切換儲存方案來減少使用者的儲存成本,對於無法預知 S3 中物件存取頻繁程度的使用者來說是一項非常貼心的儲存方案。

原先 S3 Intelligent-Tiering 僅有兩層(Frequent access、Infrequent access),此次更新後,新增了兩層(Archive、Deep archive)讓超級不常存取的物件能以更低的成本進行存放。

以下為更新後 S3 Intelligent-Tiering 的運作流程:

參考來源:Amazon S3 Intelligent-Tiering adds Archive Access Tiers — further optimizes storage costs

AWS 推出 Glue DataBrew – 可快速正規化資料的視覺化工具

假設要做帳務分析時可能會遇到公司的交易紀錄,遇到公司開業前的日期紀錄,像這種資料就不在標準值裡面,所以我們在做數據分析前們必須要讓分散、凌亂、標準不一致的資料透過 ETL 整理,這個過程好壞與數據分析的成功有非常大的影響,所以數據分析師可能會撰寫非常多的程式碼及時間在 ETL 上。

此次更新後,AWS 推出新的服務 — Glue DataBrew,幫助使用者更直觀地正規化整理資料,可過濾異常、無效的資料,執行資料的轉換,以利於後續的分析。

現在開始,可以從 Console 中,點選 AWS Glue DataBrew,使用服務。一開始必須要先創建 Project 及初始 Dataset。

使用者可選取來自 S3、Redshift、RDS 或是將第端的資料(csv、json、parquet 及 xlsx 格式)上傳到 AWS Glue DataBrew,如果選擇 S3 上傳資料,可以啟用 SSE-S3 加密。

在權限設定下,必須要給予 DataBrew 執行取用資料的權限。

接下來就可以對 Dataset 開始 ETL 動作。透過資料視覺化可以看到數據值的分佈範圍,也能去選擇隱藏、分割、結合資料,且在內建有提供 250 個的轉換範例,對於使用者進行 ETL 轉換更加快速、便利。

AWS 在達拉斯(Dallas)和邁阿密(Miami)推出新的 Wavelength Zones

Wavelength Zone 讓在同一個 Region 內的 AWS 服務,能夠透過電信商的 5G 網絡來互相溝通,加速服務之間的回覆速度。同時,也可以大幅地縮短從 5G 設備連接到 AWS 託管的服務所需的延遲。

而 Wavelength Zone 可應用於許多需要超低延遲的案例中,像是已有大量用戶的線上遊戲、虛擬實境、直播等等的案例,皆可利用 Wavelength Zone 優化應用程式的表現。

此次更新後,AWS 在達拉斯及邁阿密都新增了一個 Wavelength Zones。現在已有 7 個 Wavelength Zones 可使用,使用者可以向 AWS 發起使用 Wavelength Zones 的 request,申請通過後,就可以開始享用 5G 網路的速度了。

參考來源:Announcing new AWS Wavelength Zones in Dallas and Miami

其他服務更新

Amazon CodeGuru Profiler 支援對 AWS Lambda functions 進行效能分析

Amazon CodeGuru Profiler 可幫助使用者偵測程式碼能夠優化的地方,進而使應用程式的運行更加順暢及穩定,且助於降低成本。此次更新後,使用者只需要在 Lambda Function 上加一層 Layer,透過設定環境變數及 CodeGuru Profiler ARN,即可透過 CodeGuru Profiler 性能分析。

注意:僅限制 Runtime 為 JVM 的 Function。

現在開始,使用者創立 CodeGuru Profiler Group 後,即可透過 Start profiler in your application 的步驟,在 Lambda Function 中執行 CodeGuru Profiler。

設定好 Lambda 所需要的環境變數。

在欲想分析的 Lambda Function,按下 Add a Layer,選擇 Specify an ARN,將 CodeGuru Profiler 的 ARN 貼上去。

如此一來,透過簡單的步驟就可以使用 CodeGuru Profiler 進行程式碼優化,也期望未來還能支援更多的 Runtime。

參考來源:Amazon CodeGuru Profiler simplifies profiling for AWS Lambda functions

Amazon Elasticsearch Service 支援使用者可自定義 domain endpoint 的名稱

Amazon Elasticsearch Service 是在 AWS 平台上執行可支援 Kibana 的 Elasticsearch 的服務,使用者不需管理底層運行的機器,可直接開始使用。當使用者開始使用 Amazon Elasticsearch Service 時,Amazon Elasticsearch Service 會先創立一個 domain,並產生 domain endpoint;連結 endpoint 之後,使用者便可利用 Kibana 進行分析、搜尋及視覺化 dataset 的動作。

此次更新後,Amazon Elasticsearch Service 讓使用者可以自己定義 domain endpoint 的名稱,同時也可以將 Amazon ACM 的 SSL 憑證關聯到自定義的 domain endpoint。如果結合 Amazon Route53,當使用者需要轉移 domain name 到新的 Amazon Elasticsearch Service domain endpoint 時,就不用修改 Client 端的紀錄,仍然可以連結到 Kinbana。

參考來源:Amazon Elasticsearch Service now supports defining a custom name for your domain endpoint

Amazon DynamoDB Global Table 支援 Custom Key 加密

有許多企業在全球運營著服務、系統,為了要改善遍佈各地的使用者體驗,搭配 CloudFront,提升靜態內容存取速度。但是要將資料寫入資料庫,依據使用者與資料庫的距離,速度會有不同的影響,可能會降低使用者體驗,這時候就會有許多使用者選擇 Amazon DynamoDB Global Table,由多個 Replica Table 所組成,只要有一個 Replica 寫入變更,那麼位於其他 Region 的 Replica 也會進行變更,提供使用者更快的存取體驗。

除了可以改善資料寫入及讀取速度,資料的安全性是使用者很在乎的事情,此次更新後,也能指定 Custom Key 加密 global table 資料,降低資料遭到竊取的風險。

注意:每個 Replica 所在的區域,都必須要擁有同把金鑰才能使用。

參考來源至:Encrypt your Amazon DynamoDB global tables by using your own encryption keys

使用者現在可在 AWS Cost Management Console 畫面啟用 Savings Plans Alerts

Savings Plans 是一種可彈性配置的計價模式,如果使用者可預先預測未來 1 年或 3 年內的 Capacity 使用量,可以考慮透過 Savings Plans 的方式購買需要的 Capacity。此外,Savings Plans 可用於 Amazon EC2、AWS Lambda、Amazon ECS 以及 AWS Fargate 等多種 Computing 的資源,因此使用者可統計各個服務的用量後,一併使用 Savings Plans 購買,節省高達 72% 的成本。

對於長期使用 AWS 雲端的使用者來說,Capacity 使用量已有不少的歷史數據可幫助預測未來的用量,就會傾向使用 Savings Plans,但每當 Savings Plans 到期,使用者都必須自行紀錄到期時間,並在到期之間,購買下一期的 Savings Plans,才可以維持同樣的計價方式。

但現在,使用者可以利用 Cost Management Console,設置 Savings Plans Alerts,在 Savings Plans 即將到期時,傳送通知給使用者;或是預先購買的 Savings Plans 即將開始時,通知使用者開始的日期,保留更多的時間,讓使用者可以採取應對的動作,例如:購買下一期 Savings Plans 或是安排 Capacity 使用的時間點。

參考來源至:Savings Plans Alerts now available in AWS Cost Management

Amazon ECS 創建的 Fargate Container 優化環境變數的呼叫

以往在利用 Amazon ECS 創建 Fargate Container 時,需要用到的套件參數、API 密鑰,都必須在 Task Defination 定義,但是在操作上,非常不友善且安全性較低,如此一來擁有設定 Task Defination 權限的人員,皆可看到其配置。

此次更新後,使用者可將使用到的參數存在 AWS Secrect Manager 或是環境變數文件裡,當需要使用的時候,即可呼叫。

參考來源至:AWS Fargate for Amazon ECS launches features focused on configuration and metrics

AWS Storage Gateway 新增支援頻寬限制功能

AWS Storage Gateway 是一個混合雲儲存服務,有三種類型的 Gateway:File gateway、Tape gateway 和 Volume gateway,讓使用者能夠透過 NFS、SMB、iSCSI 或 iSCSI-VTL 來與本機中的儲存物件進行傳輸。

使用者會在使用 Storage Gateway 進行上傳物件至 AWS 時,勢必會佔用頻寬,導致使用者在本機上運行的其他應用程式會受到一定程度的影響,只能夠透過暫時停止傳輸的方式來處理。

此次更新後,AWS 針對 Tape Gateway 和 Volume Gateway 新增支援頻寬限制功能,讓使用者最大程度地減少網路壅塞,並在非高峰時段使用所有可用頻寬。

參考來源至:AWS Storage Gateway adds schedule-based network bandwidth throttling for Tape and Volume Gateway

AWS Lambda 支援 Amazon MQ for Apache ActiveMQ 作為 event source

AWS Lambda 是一項以事件觸發的 Serverless 運算服務,使用者只需要把程式碼寫入 Lambda Function,當特定事件發生,就可以觸發 Lambda 執行程式碼。此次更新後,Lambda 支援 Amazon MQ for Apache ActiveMQ 作為觸發 Lambda 執行的來源;當 messages 超過使用者設定的 batch size 或負載量超過 6MB 時,便觸發 Lambda Function 執行使用者自定義的程式碼。

若要設定 Amazon MQ for Apache ActiveMQ 作為 Lambda Function 的 event source,使用者需要進行以下步驟:

- 創建 Amazon MQ broker 並設定 MQ broker 的 security group:security group 需開啟 TCP protocol 在 61617 及 8162 port 的流量。

- 在 MQ broker 創建一個 queue

- 設定 AWS Secrets Manager 來存放能夠存取 MQ broker 的 credential

- 創建 Lambda Function,同時給予足夠權限及設定 Amazon MQ 為 event source

設定完成之後,推送到 MQ broker 的 messages,就可以交給 Lambda Function 來處理。

參考來源至:AWS Lambda now supports Amazon MQ for Apache ActiveMQ as an event source

Amazon FSx for Windows 新增支援透過其他 DNS 進行存取

Amazon FSx Windows 是一個全託管 Windows Server file system,以往使用者在創建每個 FSx 文件系統時,都會有一個用於存取它的 default DNS 名稱,使用者只能透過此 default DNS 進行存取。

此次更新後,使用者可以將其他 DNS 名稱關聯至該 default DNS 來存取該文件系統。

參考來源至:Amazon FSx for Windows File Server Now Supports Access to File Systems Using Alternate DNS Names

Amazon Translate 新增「部分文字不翻譯」的功能 – 使用者可指定部分內容保留原始狀態

Amazon Translate 是一個翻譯自然語言的 AWS 全託管的服務,使用者可利用呼叫 Amazon Translate API,將翻譯的功能結合至自己的系統,而且 Amazon Translate 支援 55 種語言,其中也包含部分不同語系的方言。當使用者利用 Amazon Translate 翻譯時,是否有遇過當文字中包含特定專有名詞或是程式語言時,Amazon Translate 翻譯的準確度就會有些降低?

此次更新後,Amazon Translate 支援「部分文字不翻譯」的功能,使用者可透過 HTML 的 <span> 標籤,並設定 <span> 的 attribute:translate = no,即可保留文字原本的樣子。

除了可以從 AWS Console 直接使用新功能,也可以使用 API 呼叫,同樣利用 <span> 表示不需要翻譯的文字,也會得到同樣的結果。

aws translate translate-text \

--source-language-code "en" \

--target-language-code "es" \

--region us-west-2 \

--text “This can be translated to any language. <p translate=no>But do not translate this!</p>”

參考來源至:Amazon Translate allows user to specify a part of the text to not be translated – Do Not Translate

圖片來源至:Amazon Translate now enables you to mark content to not get translated

Amazon S3 Replication 新增支援 metrics 及 notifications

Amazon S3 的 Metrics 及 Event notifications 功能可幫助使用者監控 S3 bucket 的狀態,同時在發生錯誤或失敗時,接收到通知以利快速地採取應對措施;而原先,如果有設定 Replication Time Control (S3 RTC) 的 replication rule,才可以啟用 Metrics 及 Event notifications 的功能,若未在 15 分鐘內複寫完成,可傳送通知到 SQS Queue、SNS Topic,或是觸發 Lambda,同時也可以在 Replication Metrics 看到複寫過程中所發生的狀態變化。

此次更新後,所有的 replication rule 皆可以啟用 Metrics 及 Event notifications。如果 replication rule 設定有誤,使用者也就更容易進行偵錯。

參考來源至:Amazon S3 Replication adds support for metrics and notifications

Amazon S3 Replication 新增支援複寫 delete markers 至 destination bucket

Amazon S3 Replication 的功能可以讓使用者複寫特定 S3 Bucket 1 中的物件至不同 Region 或是相同 Region 中的另一個 S3 Bucket;甚至可以跨帳號的複寫,意味著即使兩個 Bucket 的擁有者不同,只要給予彼此足夠的權限,也可以進行複寫的動作。

在開始使用 S3 的 Replication 功能之前,來源端與目的地端的 bucket 都需要啟用 Versioning,並且 Replication 僅會複寫在設定 replication rule 之後所 創立 的物件,不溯及既往。而原先,S3 Replication 也不會複寫 刪除 事件,也就是 不會複寫 delete marker,因此即使刪除 source bucket 裡的物件,也不會影響到 destination bucket 物件的狀態。

但上述的情況,對於希望能夠同步兩邊 bucket 裡物件狀態的使用者而言,就需要自行刪除兩邊 bucket 裡的物件,才能夠保持一樣。此次更新後,使用者不需要再自行同步,而是 可以在 replication rule 裡指定複寫 delete marker。

舉例來說:以下的範例將會複寫 prefix 為 Tax 的物件至 DOC-EXAMPLE-BUCKET bucket。

{

"Rules": [

{

"Status": "Enabled",

"Filter": {

"Prefix": "Tax"

},

"DeleteMarkerReplication": {

"Status": "Enabled"

},

"Destination": {

"Bucket": "arn:aws:s3:::DOC-EXAMPLE-BUCKET"

},

"Priority": 1

}

],

"Role": "IAM-Role-ARN"

}

參考來源至:Amazon S3 Replication adds support for replicating delete markers

Amazon EventBridge 新增支援事件重播

Amazon EventBridge 是一個無伺服器的事件匯流排服務,可讓使用者自己的應用程式與其他 SaaS 服務或 AWS 服務之間彼此進行溝通,例如:EventBridge 可從事件來源(Auth0、Zendesk、Datadog或 Pagerduty)提供 real-time 的事件推送,並可將該訊息傳送至 Lambda 進行觸發。

事件觸發作為一個開端並不會因為最後結果成功與否而有所改變,因此有時使用者想重複相同事件時,會需要想辦法再次觸發相同事件,例如:使用者修復了應用程式錯誤後,想要重新測試或彌補錯誤以獲得正確的結果。

此次更新後,EventBridge 支援事件重播(Event Replay)功能,開發人員可以選擇重播至哪個 event bus 並設定開始和的結束時間,讓使用者能夠更快速的完成上述需求。

參考來源至:Amazon EventBridge introduces support for Event Replay

AWS Database Migration 新增 Amazon DocumentDB 資料庫轉換

AWS Database Migration 是一個可以搬遷資料庫的服務,不管是關聯式資料庫、NoSQL 資料庫或其他類型的資料庫存儲,都可以透過 AWS DMS 安全地將資料搬遷到雲端上、或者是搬遷回地端,不僅如此使用者也可以透過它轉移其他類型資料庫,像是將 MySQL 轉換成 PostgreSQL,或是其他 NoSQL 資料庫。

此次更新後,AWS DMS 支援將資料庫引擎搬遷、轉換到 DocumentDB Cluster。

AWS Snowball Edge 支援匯入 VM 映像檔

AWS Snowball Edge 是一個用於大規模資料搬遷的實體儲存裝置,內建儲存與運算能力,分為Storage Optimized 和 Compute Optimized,以支援在無網路的環境下 (例如:船上、山上) 進行本機資料處理和收集。

此次更新後,支援將 VM 的映像檔作為 AMI 導入 Snowball Edge 中,從而減少在 edge 端新增或更新 AMI 所需的時間,此功能皆適用於 Compute Optimized 和 Storage Optimized ,並且在所有支援這些設備類型的 AWS 區域中使用而且無需支付額外費用。

參考來源至:AWS Snowball Edge now supports importing virtual machine images to your deployed Snow devices

AWS Snowball Edge 新增支援 Windows 作業系統

原先使用者僅能在 Snowball 上運行 Ubuntu 或 CentOS Linux 為作業系統的 instances。此次更新後,使用者可以在 Snowball Edge Compute Optimized 或是 Snowball Edge Storage Optimized 上運行 Windows 的 workload;對於習慣使用 Windows 系統的使用者而言,如果想把系統搬遷至 AWS 雲端,多了一種搬遷大量資料的選擇。

如果想開始在 Snowball Edge 上運行 Windows 的 workload,使用者需要在自身帳戶內,擁有一個具有有效 Windows License 的 AMI 才可以開始創建 Windows workload 的 Snow job。

參考來源至:AWS Snowball Edge now supports Windows operating systems

AWS Client VPN 新增支援 Client Connect Handler

AWS VPN 可讓使用者自身的地端環境、裝置,與 AWS 之間建立安全連線。AWS VPN 包括兩項服務:AWS Site-to-Site VPN 和 AWS Client VPN。其中,AWS Client VPN 以發放憑證的方式,作為驗證 Client 端能否連結 AWS 資源的依據;舉例來說,當使用者想要從遠端環境連結到 AWS 時,需透過 VPN client application,並帶有認證且有效的憑證,才能夠建立連線。

此次更新後,當 Client 端已通過身份驗證並開始建立連線時,使用者可利用 Client Connect Handler,在連線建立的期間,使用自定義的授權機制,以符合原先組織內部規定。例如:Handler 可讓 IT administrators 設定「基於 Client 端的 IP 或是地理位置」當作給予多少權限的判斷標準;或是檢查 Client 端建立連線的裝置是否合規、安全;也可以搜集 Client 端在建立連線過程中所產生的審核訊息。

Amazon Neptune 新增支援事件類型的通知

Amazon Neptune 是一個全託的圖形資料庫,支援兩種熱門的圖形查詢語言:Apache TinkerPop Gremlin 和 W3C 的 SPARQL。

以往當使用者想要得知 Neptune 運行狀況時,都必須親自去 Neptune 主控台檢視目前狀態,此次更新後,使用者可以針對像是:Neptune DB Cluster、DB instances、Snapshots、Parameter group、Security groups 設定事件通知。

目前 Neptune 支援的事件多達 80 種,所以當使用者設定完成後,可以做到像是透過 SNS 收到 Patch 完成、DB Instance failover 完成或 Security group 被修改之類的事件通知,並且可以透過 Lambda 進行後續行為,即時了解 Neptune 目前運行狀態。

AWS Systems Manager Explorer 支援跨 Account 及 Region 檢查合規狀態

企業在開發或維護系統時,需要維持環境的一致性,以往會借助 AWS Config Rule 檢查資源或操作是否有符合合規性,助於保持環境安全,此次更新後,在管理上又提升了一個層級,AWS Systems Manager Explorer 現在可以跨Account 及 Region 提供檢查合規性狀態的儀表板,如此一來,企業可以方便地去設定、監控環境的安全,也能透過 Amazon SNS 發送狀態的訊息,讓管理人員可以隨時知道環境的狀態為何。

Amazon Redshift 新增支援兩種資料類型:TIME 及 TIMETZ

Amazon Redshift 是一個資料倉儲的服務,可儲存高達 PB 級的資料,同時支援使用標準 SQL 語言及 BI 工具來分析資料。原先 Redshift 可存放 DATE(僅包含日期)、TIMESTAMP(包含日期和時間)及 TIMESTAMPTZ(包含日期、時間、時區)三種與日期和時間相關的資料型態,因此當使用者利用 SQL function 做資料 query 的時候,需要加入額外的處理,才可以拆分日期與時間成分開的資料。

此次更新後,Redshift 新增支援 TIME(僅包含時間)及 TIMETZ(包含時間與時區)兩種資料類型,使用者可直接將日期與時間分開儲存在 Redshift Cluster,做資料 query 時,也不需要再額外做拆分的動作。

參考來源至:Amazon Redshift announces support for TIME and TIMETZ data types

Amazon Polly 推出新的聲音風格:British English Newscaster

Amazon Polly 是一項可將文字轉為語音的服務,而 AWS 也持續增加 Polly 語音的風格,使用者可根據使用場景的不同,選擇不同語言、性別、職業、口音…等不同的聲音風格來讓 Polly 的聲音更貼合實際需求。例如:如果多數收聽語音的人,是來自墨西哥的聽眾,且習慣聽西班牙語,那麼使用者就可以選擇 Spanish (Mexican) 作為 Polly 轉譯的聲音。

此次更新後,Polly 推出了 British English Newscaster – Amy 的聲音風格,Amy 模仿了英國新聞播報員的正規口音,未來期望模仿英國新聞員的使用者,不妨可以試試利用 Polly 來錄製廣播節目,就好比真的新聞播報員在講述新聞一樣。

參考來源至:Amazon Polly launches a British English Newscaster speaking Style

Tag:Account, Amazon CodeGuru Profiler, Amazon DocumentDB, Amazon DynamoDB, Amazon DynamoDB Global Table, Amazon ECS, Amazon Elasticsearch Service, Amazon EventBridge, Amazon FSx for Windows, Amazon MQ, Amazon Neptune, Amazon Polly, Amazon Redshift, Amazon S3 Intelligent-Tiering, Amazon S3 Replication, Amazon Translate, Apache ActiveMQ, Archive Access Tiers, AWS, AWS Client VPN, AWS Cost Management Console, AWS Database Migration, AWS Gateway Load Balancer, AWS Lambda, AWS Lambda functions, AWS Snowball Edge, AWS Storage Gateway, AWS Systems Manager Explorer, British English Newscaster, Client Connect Handler, CSV, Custom Key, delete markers, destination bucket, DNS, domain endpoint, event source, Fargate Container, Glue DataBrew, Metrics, notifications, Region, S3 bucket, Savings Plans Alerts, Table, VM, Wavelength Zones, Windows